Dies bedeutet, dass sie nicht das gesamte Internet abdecken – auch nicht die Informationen einer kleinen inhabergeführten Brauerei aus Unterfranken oder die Produktdaten eines mittelständischen Maschinenbauers aus dem Emsland.

Neben der Öffnung von Sprachmodellen in Richtung Internet (Magazinbeitrag: Websuche) ist die Bereitstellung unternehmensspezifischer Informationen der entscheidende Schritt, um hochwertige, nutzbare und wertschöpfende Antworten von KI- und Sprachmodellen zu erhalten. Erst wenn ein LLM umfassende Daten und Informationen zu einem Produkt oder Unternehmen erhält, kann es einem Support- oder Vertriebsmitarbeiter sowie Kunden oder Interessenten hilfreiche Antworten geben.

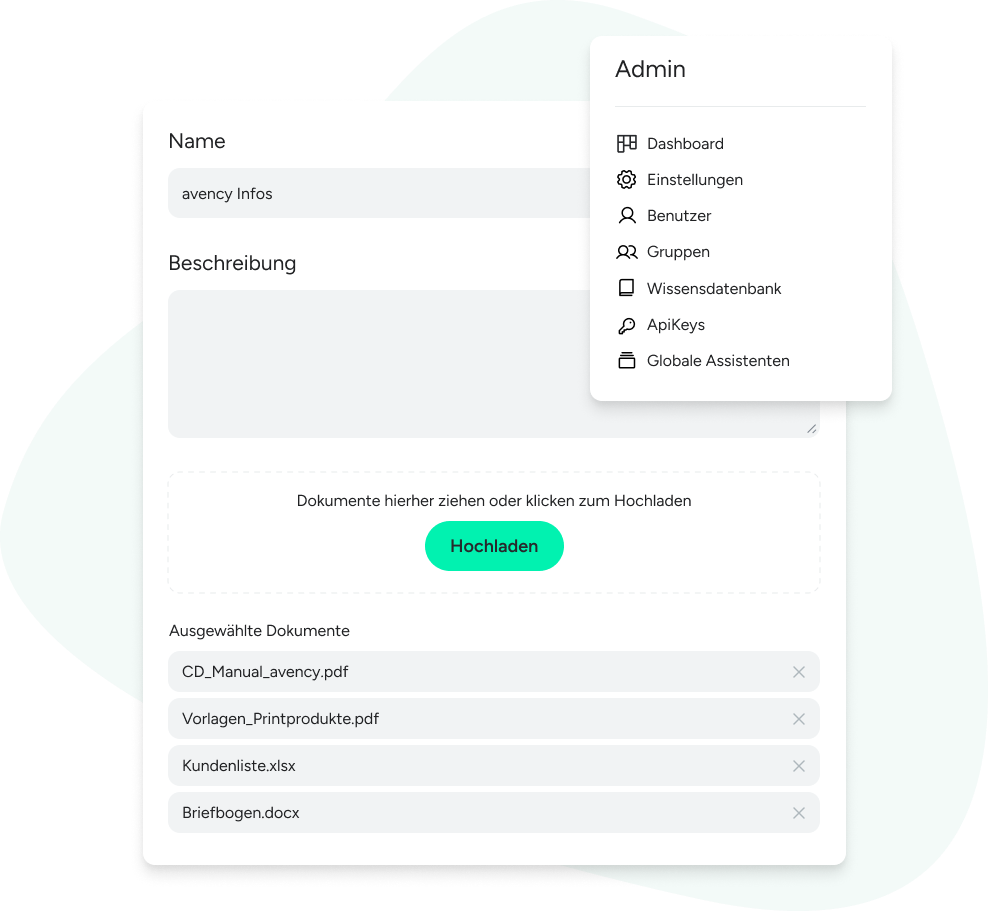

Die Daten werden innerhalb der VARIOS AI-Wissensdatenbank abgelegt und gespeichert. Bei lokalem Embedding erhalten öffentliche Sprachmodelle und ihre Anbieter keinen Zugriff auf diese Daten und Dokumente. Lediglich der Anwender steuert über seine Anweisungen an das LLM, welche Daten aus der Wissensdatenbank verarbeitet werden sollen.

Stellen Sie sich vor, wie Ihre Mitarbeiter mit KI-gestützten, präzisen Antworten ihre Effizienz steigern können. Entdecken Sie jetzt den Mehrwert unseres neuen Features und nutzen Sie die Möglichkeiten der intelligenten Datenintegration!